사전학습이란?

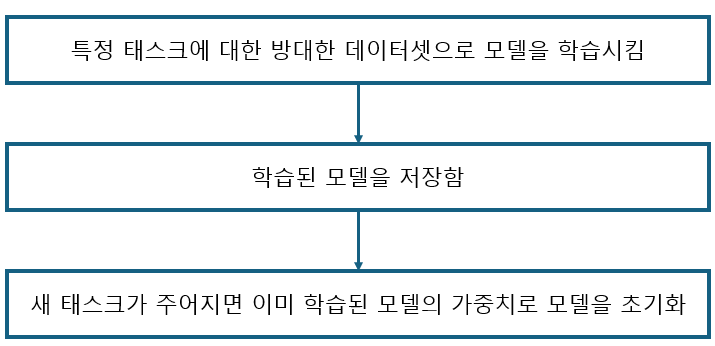

사전학습된 모델을 사용하여 모델을 학습시킬 경우 프로세스는 다음과 같다.

즉, 모델이 이미 대규모 데이터셋에서 학습되었기 때문에 새 태스크를 위해 새로운 모델로 처음부터 학습시킬 필요가 없다. 일반적으로 사전 학습된 모델을 사용할 경우 새로운 태스크에 따라 가중치를 조정(파인튜닝)하는 과정만 거치면 된다.

BERT는 MLM과 NSP라는 두 가지 태스크를 이용해 거대한 말뭉치를 기반으로 사전학습된다. 사전학습 후 사전 학습된 BERT를 저장해두고 새로운 태스크가 주어지면 사전 학습된 BERT를 사용한다.

Masked Language Model (MLM)

MLM은 주어진 문장에서 무작위로 몇 개의 단어를 마스킹하고, 모델이 이러한 마스킹된 단어를 예측하도록 하는 태스크이다. 모델은 마스킹된 단어의 위치에 있는 토큰을 예측하기 위해 문맥을 고려하여 임베딩된 벡터를 생성한다. 이를 통해 모델은 문장 내의 단어들 간의 상호 작용과 문맥을 이해하는 데 필요한 정보를 학습한다.

Next Sentence Prediction (NSP)

NSP는 두 문장이 주어졌을 때, 두 번째 문장이 첫 번째 문장의 바로 다음에 오는 문장인지 여부를 예측하는 태스크이다. 이를 통해 모델은 문장 간의 관계와 문맥을 이해하는 데 필요한 정보를 학습한다. 예를 들어, "I like dogs."와 "They bark loudly."가 주어졌을 때, NSP 태스크는 두 번째 문장이 첫 번째 문장 바로 다음에 오는 문장인지 여부를 판단한다.

전이학습(Transfer Learning)이란?

전이 학습은 사전 훈련된 모델을 새로운 작업에 활용하는 기계 학습 방법이다. 이는 한 작업에서 훈련된 모델을 다른 작업에 재사용하여 빠른 진행을 가능하게 한다. 새로운 작업에 대해 전이 학습을 적용하면 적은 양의 데이터로도 높은 성능을 얻을 수 있다. 하지만 전이학습은 너무 일반적이어서 이미지 또는 자연어 처리 관련 작업에 대한 모델을 처음부터 훈련하는 경우는 흔하지 않은 편이다.

사전학습과 전이학습의 차이점

전이 학습은 이미 사전 학습된 모델을 가져와서 새로운 작업에 맞게 조정하는 과정인 반면, 사전 학습은 모델이 일반적(범용적)인 지식을 학습하는 초기 과정이다. 전이 학습은 사전 학습된 모델을 가져와 특정 작업에 적용하고 세밀하게 조정하는 것이며, 이는 새로운 작업에 대해 빠른 학습을 가능케 한다. 반면 사전 학습은 모델이 데이터를 미리 학습하여 일반적인 특징과 패턴을 습득하는 단계로, 이후에 전이 학습에 활용될 수 있다.

전이학습과 파인튜닝의 차이점

전이 학습과 파인 튜닝은 모두 기존에 학습된 모델을 새로운 작업에 활용하는 방법이라는 점에서 공통점이 있지만, 차이점도 존재한다. 파인 튜닝은 사전에 학습된 모델을 가져와서 그 모델의 일부 레이어를 새로운 작업에 맞게 조정하는 과정이지만, 전이 학습은 사전 학습된 모델 전체를 가져와서 새로운 작업에 맞게 조정하는 과정이다. 즉, 파인 튜닝은 모델의 일부를 조정하여 새로운 작업에 맞게 최적화하는 반면, 전이 학습은 모델 전체를 사용하여 새로운 작업에 맞게 재조정하는 것입니다.

참고문헌

Deep Learning Bible - 2. Classification

"구글 BERT의 정석"

'Deep Learning > NLP' 카테고리의 다른 글

| BERT 파생 모델: ELECTRA, RoBERTa, DeBERTa (1) | 2024.10.07 |

|---|---|

| BERT 사전학습(3) - 언어 모델링의 종류 (0) | 2024.10.07 |

| BERT 사전 학습(2) - BERT의 입력 표현 (1) | 2024.10.07 |

| BERT의 구조 (0) | 2024.10.07 |

| BERT의 동작 방식 (1) | 2024.10.07 |